Inteligencia artificial

Definición

| Inteligencia artificial |

| Objetivos principales |

|---|

| Razonamiento del conocimiento |

| Planificación |

| Aprendizaje automático |

| Procesamiento natural del lenguaje |

| Visión por computador |

| Robótica |

| Inteligencia general artificial |

| Enfoques |

| Simbólico |

| Aprendizaje profundo |

| Redes bayesianas |

| Algoritmos evolutivos |

| Filosofía |

| Ética |

| Riesgo existencial |

| prueba de Turing |

| Habitación china |

| Amigable |

| Historia |

| Cronología |

| Progreso |

| AI invierno |

| Tecnología |

| Aplicaciones |

| Proyectos |

| Lenguajes de programación |

| Glosario |

| Glosario |

El alcance de AI es controvertido: a medida que las máquinas se vuelven cada vez más capaces, las tareas consideradas que requieren "inteligencia" a menudo se eliminan de la definición, un fenómeno conocido como el efecto AI, que lleva a la ocurrencia, "AI es lo que no se ha hecho aún " Por ejemplo, el reconocimiento óptico de caracteres a menudo se excluye de la "inteligencia artificial", convirtiéndose en una tecnología de rutina. Las capacidades generalmente clasificadas como AI a partir de 2017 incluyen comprender con éxito el habla humana, competir al más alto nivel en sistemas de juegos estratégicos (como ajedrez y go), autos autónomos, enrutamiento inteligente en la red de distribución de contenido y simulaciones militares.

La inteligencia artificial se fundó como una disciplina académica en 1956, y en los años posteriores ha experimentado varias oleadas de optimismo, seguidas por la decepción y la pérdida de fondos (conocida como "invierno AI"), seguidas de nuevos enfoques, éxito y financiación renovada. . Durante la mayor parte de su historia, la investigación en IA se ha dividido en subcampos que a menudo no se comunican entre sí. Estos subcampos se basan en consideraciones técnicas, como objetivos particulares (por ejemplo, "robótica" o "aprendizaje automático"), el uso de herramientas particulares ("lógica" o redes neuronales artificiales) o profundas diferencias filosóficas. Los subcampos también se han basado en factores sociales (instituciones particulares o el trabajo de investigadores particulares).

Los problemas (u objetivos) tradicionales de la investigación en IA incluyen el razonamiento, la representación del conocimiento, la planificación, el aprendizaje, el procesamiento del lenguaje natural, la percepción y la capacidad de mover y manipular objetos. La inteligencia general es una de las metas a largo plazo del campo. Los enfoques incluyen métodos estadísticos, inteligencia computacional e IA simbólica tradicional. Se utilizan muchas herramientas en IA, incluidas las versiones de búsqueda y optimización matemática, redes neuronales artificiales y métodos basados en estadísticas, probabilidad y economía. El campo de la IA se basa en ciencias de la computación, matemáticas, psicología, lingüística, filosofía y muchos otros.

El campo se fundó en la afirmación de que la inteligencia humana "puede describirse con tanta precisión que se puede hacer que una máquina lo simule". Esto plantea argumentos filosóficos sobre la naturaleza de la mente y la ética de crear seres artificiales dotados de inteligencia humana, temas que han sido explorados por el mito, la ficción y la filosofía desde la antigüedad. Algunas personas también consideran que la IA es un peligro para la humanidad si progresa sin cesar. Otros creen que la IA, a diferencia de revoluciones tecnológicas previas, creará un riesgo de desempleo masivo.

En el siglo XXI, las técnicas de IA han experimentado un resurgimiento tras los avances concurrentes en el poder de las computadoras, grandes cantidades de datos y comprensión teórica; y las técnicas de AI se han convertido en una parte esencial de la industria de la tecnología, ayudando a resolver muchos problemas desafiantes en la informática.

Historia

Los seres artificiales con capacidad de pensamiento aparecieron como dispositivos narrativos en la antigüedad, y han sido comunes en la ficción, como en Frankenstein de Mary Shelley o RUR de Karel Čapek (Robots universales de Rossum) . Estos personajes y sus destinos plantearon muchos de los mismos problemas ahora discutidos en la ética de la inteligencia artificial.

El estudio del razonamiento mecánico o "formal" comenzó con filósofos y matemáticos en la antigüedad. El estudio de la lógica matemática condujo directamente a la teoría de la computación de Alan Turing, que sugería que una máquina, al barajar símbolos tan simples como "0" y "1", podría simular cualquier acto concebible de deducción matemática. Esta idea, que las computadoras digitales pueden simular cualquier proceso de razonamiento formal, se conoce como la tesis de Church-Turing. Junto con los descubrimientos concurrentes en neurobiología, teoría de la información y cibernética, esto llevó a los investigadores a considerar la posibilidad de construir un cerebro electrónico. Turing propuso que "si un ser humano no pudiera distinguir entre las respuestas de una máquina y un ser humano, la máquina podría considerarse" inteligente ".

El campo de la investigación en IA nació en un taller en Dartmouth College en 1956. Los asistentes Allen Newell (CMU), Herbert Simon (CMU), John McCarthy (MIT), Marvin Minsky (MIT) y Arthur Samuel (IBM) se convirtieron en los fundadores y líderes de la investigación de IA. Ellos y sus estudiantes produjeron programas que la prensa describió como "asombrosos": las computadoras aprendían estrategias de los inspectores (hacia 1954) (y en 1959 supuestamente jugaban mejor que el humano promedio), resolviendo problemas verbales en álgebra, probando teoremas lógicos (Lógica Teórico, primera ejecución hacia 1956) y hablando inglés. A mediados de la década de 1960, la investigación en los EE. UU. Estaba fuertemente financiada por el Departamento de Defensa y se habían establecido laboratorios en todo el mundo. Los fundadores de AI se mostraron optimistas sobre el futuro: Herbert Simon predijo: "las máquinas serán capaces, dentro de veinte años,

No pudieron reconocer la dificultad de algunas de las tareas restantes. El progreso se ralentizó y en 1974, en respuesta a las críticas de Sir James Lighthill y la presión actual del Congreso de los EE. UU. Para financiar proyectos más productivos, tanto los gobiernos de los Estados Unidos como los de Gran Bretaña suspendieron la investigación exploratoria en IA. Los próximos años se llamarían más tarde un "invierno AI", un período en el que era difícil obtener fondos para proyectos de IA.

A principios de los años ochenta, la investigación en IA fue revivida por el éxito comercial de los sistemas expertos, una forma de programa de IA que simulaba el conocimiento y las habilidades analíticas de los expertos humanos. En 1985, el mercado de IA había alcanzado más de mil millones de dólares. Al mismo tiempo, el proyecto informático de quinta generación de Japón inspiró a los gobiernos de Estados Unidos y Gran Bretaña a restablecer los fondos para la investigación académica. Sin embargo, a partir del colapso del mercado de Lisp Machine en 1987, AI cayó una vez más en el descrédito y comenzó un segundo hiato más duradero.

A fines de la década de 1990 y principios del siglo XXI, AI comenzó a utilizarse para logística, extracción de datos, diagnóstico médico y otras áreas. El éxito se debió al aumento del poder computacional (ver la ley de Moore), mayor énfasis en resolver problemas específicos, nuevos vínculos entre IA y otros campos (como estadísticas, economía y matemáticas) y el compromiso de los investigadores con los métodos matemáticos y los estándares científicos. Deep Blue se convirtió en el primer sistema de reproducción de ajedrez por computadora que venció al campeón reinante de ajedrez mundial, Garry Kasparov, el 11 de mayo de 1997.

En 2011, ¡un Jeopardy! concurso de exhibición de pruebas, el sistema de preguntas y respuestas de IBM, Watson, ¡derrotó a los dos Jeopardy más grandes ! campeones, Brad Rutter y Ken Jennings, por un margen significativo. Las computadoras más rápidas, las mejoras algorítmicas y el acceso a grandes cantidades de datos permitieron avances en el aprendizaje y la percepción de las máquinas; Los métodos de aprendizaje profundo hambrientos de datos comenzaron a dominar los puntos de referencia de precisión alrededor de 2012. Kinect, que proporciona una interfaz 3D de movimiento corporal para Xbox 360 y Xbox One, usa algoritmos que surgieron de largas investigaciones de inteligencia artificial como los asistentes personales inteligentes en teléfonos inteligentes. En marzo de 2016, AlphaGo ganó 4 de 5 juegos de Go en un partido con el campeón de Go, Lee Sedol, convirtiéndose en el primer sistema de Go-playing de la computadora en vencer a un jugador profesional de Go sin handicaps. En la Cumbre Future of Go 2017, AlphaGo ganó un partido de tres juegos con Ke Jie, quien en ese momento mantuvo continuamente el ranking mundial número uno durante dos años.

Según Jack Clark, de Bloomberg, 2015 fue un año clave para la inteligencia artificial, y el número de proyectos de software que usan inteligencia artificial en Google aumentó desde un "uso esporádico" en 2012 a más de 2.700 proyectos. Clark también presenta datos factuales que indican que las tasas de error en las tareas de procesamiento de imágenes han disminuido significativamente desde 2011. Lo atribuye a un aumento de redes neuronales asequibles, debido a un aumento en la infraestructura de computación en la nube y un aumento en las herramientas de investigación y conjuntos de datos. Otros ejemplos citados incluyen el desarrollo de Microsoft de un sistema de Skype que puede traducir automáticamente de un idioma a otro y el sistema de Facebook que puede describir imágenes a personas ciegas. En una encuesta de 2017, una de cada cinco empresas informó que había "incorporado AI en algunas ofertas o procesos".

Lo esencial

Una IA típica percibe su entorno y realiza acciones que maximizan sus posibilidades de alcanzar sus objetivos con éxito. La función de objetivo de una IA puede ser simple ("1 si la IA gana un juego de Go, 0 en caso contrario") o compleja ("Realice acciones matemáticamente similares a las acciones que le dieron recompensas en el pasado"). Los objetivos se pueden definir explícitamente o se pueden inducir. Si la IA está programada para el "aprendizaje de refuerzo", los objetivos pueden ser inducidos implícitamente al recompensar algunos tipos de comportamiento y castigar a otros. Alternativamente, un sistema evolutivo puede inducir objetivos mediante el uso de una "función de acondicionamiento físico" para mutar y replicar preferentemente los sistemas de IA de alta puntuación; esto es similar a cómo evolucionaron los animales para desear innatamente ciertos objetivos, como encontrar comida, o cómo los perros pueden ser criados a través de selección artificial para poseer los rasgos deseados. Algunos sistemas de IA, como el vecino más cercano, en cambio razonan por analogía; estos sistemas generalmente no tienen objetivos, excepto en la medida en que los objetivos están de alguna manera implícitos en sus datos de entrenamiento. Dichos sistemas aún pueden ser evaluados si el sistema no objetivo se enmarca como un sistema cuyo "objetivo" es lograr con éxito su tarea de clasificación estrecha.

AI a menudo gira en torno al uso de algoritmos. Un algoritmo es un conjunto de instrucciones inequívocas que una computadora mecánica puede ejecutar. Un algoritmo complejo a menudo se construye sobre otros algoritmos más simples. Un ejemplo simple de un algoritmo es la siguiente receta para jugar de forma óptima en el tic-tac-toe:

- Si alguien tiene una "amenaza" (es decir, dos en una fila), toma el cuadrado restante. De otra manera,

- si un movimiento "se bifurca" para crear dos amenazas a la vez, juega ese movimiento. De otra manera,

- toma el cuadrado central si es gratis. De otra manera,

- si tu oponente ha jugado en una esquina, toma la esquina opuesta. De otra manera,

- tomar una esquina vacía si existe. De otra manera,

- toma cualquier cuadrado vacío.

Muchos algoritmos de IA son capaces de aprender de los datos; pueden mejorar a sí mismos aprendiendo nuevas heurísticas (estrategias o "reglas de oro", que han funcionado bien en el pasado), o pueden escribir otros algoritmos. Algunos de los "aprendices" descritos a continuación, incluidas las redes bayesianas, los árboles de decisión y el vecino más cercano, teóricamente podrían aprender a aproximarse a cualquier función, incluyendo la combinación de funciones matemáticas que mejor describa la información infinita, el tiempo y la memoria. el mundo entero. Por lo tanto, estos estudiantes podrían, en teoría, derivar todo el conocimiento posible, al considerar cada hipótesis posible y compararla con los datos. En la práctica, casi nunca es posible considerar todas las posibilidades, debido al fenómeno de "explosión combinatoria", donde la cantidad de tiempo necesaria para resolver un problema crece exponencialmente. Gran parte de la investigación en IA implica descubrir cómo identificar y evitar considerar amplias franjas de posibilidades que es poco probable que sean fructíferas. Por ejemplo, al ver un mapa y buscar la ruta de conducción más corta desde Denver a Nueva York en el este, en la mayoría de los casos puede omitir mirar cualquier camino a través de San Francisco u otras áreas lejanas al oeste; por lo tanto, una IA que maneje un algoritmo de determinación de ruta como A * puede evitar la explosión combinatoria que se produciría si todas las rutas posibles tuvieran que ser consideradas a la vez. Al ver un mapa y buscar la ruta más corta desde Denver a Nueva York en el este, en la mayoría de los casos puede omitir mirar cualquier camino a través de San Francisco u otras áreas lejanas al oeste; por lo tanto, una IA que maneje un algoritmo de determinación de ruta como A * puede evitar la explosión combinatoria que se produciría si todas las rutas posibles tuvieran que ser consideradas a la vez. Al ver un mapa y buscar la ruta más corta desde Denver a Nueva York en el este, en la mayoría de los casos puede omitir mirar cualquier camino a través de San Francisco u otras áreas lejanas al oeste; por lo tanto, una IA que maneje un algoritmo de determinación de ruta como A * puede evitar la explosión combinatoria que se produciría si todas las rutas posibles tuvieran que ser consideradas a la vez.

El enfoque más temprano (y el más fácil de entender) para la IA fue el simbolismo (como la lógica formal): "Si un adulto sano por lo demás tiene fiebre, entonces es posible que tenga influenza". Un segundo enfoque, más general, es la inferencia bayesiana: "Si el paciente actual tiene fiebre, ajuste la probabilidad de que tenga influenza de esa manera". El tercer enfoque principal, extremadamente popular en las aplicaciones de AI de rutina, son los analizadores como SVM y el vecino más cercano: "Después de examinar los registros de pacientes pasados conocidos cuya temperatura, síntomas, edad y otros factores coinciden mayormente con el paciente actual, X% de esos pacientes resultó tener gripe ". Un cuarto enfoque es más difícil de entender intuitivamente, pero está inspirado en cómo funciona la maquinaria del cerebro: el enfoque de red neuronal artificial usa artificial " por ejemplo, las redes neuronales pueden aprender a hacer inferencias, generalizar y hacer analogías. Algunos sistemas utilizan implícita o explícitamente múltiples de estos enfoques, junto con muchos otros algoritmos de IA y no de IA; el mejor enfoque a menudo es diferente dependiendo del problema. por ejemplo, las redes neuronales pueden aprender a hacer inferencias, generalizar y hacer analogías. Algunos sistemas utilizan implícita o explícitamente múltiples de estos enfoques, junto con muchos otros algoritmos de IA y no de IA; el mejor enfoque a menudo es diferente dependiendo del problema.

Los algoritmos de aprendizaje funcionan sobre la base de que las estrategias, algoritmos e inferencias que funcionaron bien en el pasado probablemente continuarán funcionando bien en el futuro. Estas inferencias pueden ser obvias, como "dado que el sol salió todas las mañanas durante los últimos 10.000 días, probablemente también se levantará mañana por la mañana". Se pueden matizar, como "X% de las familias tienen especies geográficamente separadas con variantes de color, por lo que existe un% de probabilidad de que existan cisnes negros no descubiertos". Los estudiantes también trabajan sobre la base de la "navaja de afeitar de Occam": la teoría más simple que explica los datos es la más probable. Por lo tanto, para tener éxito, un alumno debe diseñarse de modo que prefiera teorías más simples a teorías complejas, excepto en los casos en que la teoría compleja se demuestra sustancialmente mejor. Sentarse en un mal, la teoría demasiado compleja manipulada para adaptarse a todos los datos de entrenamiento anteriores se conoce como sobreajuste. Muchos sistemas intentan reducir el sobreajuste recompensando una teoría de acuerdo con cuán bien encaja con los datos, pero penalizando la teoría de acuerdo con cuán compleja es la teoría. Además del sobreajuste clásico, los alumnos también pueden decepcionarse al "aprender la lección equivocada". Un ejemplo de juguete es que un clasificador de imágenes entrenado solo en imágenes de caballos marrones y gatos negros podría concluir que todos los parches marrones probablemente sean caballos. Un ejemplo del mundo real es que, a diferencia de los humanos, los clasificadores de imágenes actuales no determinan la relación espacial entre los componentes de la imagen; en su lugar, aprenden patrones abstractos de píxeles que los humanos no tienen en cuenta, pero que se correlacionan linealmente con imágenes de ciertos tipos de objetos reales.

Comparado con los humanos, AI existente carece de varias características del "razonamiento de sentido común" humano; lo más notable es que los humanos tenemos mecanismos poderosos para razonar sobre la "física ingenua", como el espacio, el tiempo y las interacciones físicas. Esto permite que incluso los niños pequeños hagan fácilmente inferencias como "Si tiro este bolígrafo de una mesa, caerá al piso". Los humanos también tienen un poderoso mecanismo de "psicología popular" que les ayuda a interpretar oraciones en lenguaje natural como "Los concejales de la ciudad rechazaron un permiso a los manifestantes porque abogaban por la violencia". (Una IA genérica tiene dificultades para inferir si los concejales o los manifestantes son los que supuestamente defienden la violencia). Esta falta de "conocimiento común" significa que la IA a menudo comete errores diferentes a los que cometen los humanos, de maneras que pueden parecer incomprensibles. Por ejemplo, los autos que circulan por sí mismos no pueden razonar acerca de la ubicación ni las intenciones de los peatones de la manera exacta en que lo hacen los humanos, y en su lugar deben usar modos de razonamiento no humanos para evitar accidentes.

Problemas

El objetivo general de investigación de la inteligencia artificial es crear tecnología que permita que las computadoras y las máquinas funcionen de manera inteligente. El problema general de simular (o crear) inteligencia se ha dividido en subproblemas. Estos consisten en rasgos o capacidades particulares que los investigadores esperan que muestre un sistema inteligente. Los rasgos descritos a continuación han recibido la mayor atención.

Razonamiento, resolución de problemas

Los primeros investigadores desarrollaron algoritmos que imitaban el razonamiento paso a paso que usan los humanos cuando resuelven acertijos o hacen deducciones lógicas. A fines de los años ochenta y noventa, la investigación en IA había desarrollado métodos para tratar con información incierta o incompleta, empleando conceptos de probabilidad y economía.

Estos algoritmos demostraron ser insuficientes para resolver grandes problemas de razonamiento, porque experimentaron una "explosión combinatoria": se volvieron exponencialmente más lentos a medida que los problemas crecían. De hecho, incluso los humanos rara vez usan la deducción paso a paso que la investigación temprana de IA fue capaz de modelar. Resuelven la mayoría de sus problemas usando juicios rápidos e intuitivos.

Representación del conocimiento

La representación del conocimiento y la ingeniería del conocimiento son fundamentales para la investigación clásica de AI. Algunos "sistemas expertos" intentan reunir conocimiento explícito poseído por expertos en un dominio restringido. Además, algunos proyectos intentan reunir el "conocimiento de sentido común" conocido por la persona promedio en una base de datos que contiene amplios conocimientos sobre el mundo. Entre las cosas que una base de conocimiento de sentido común integral contendría se encuentran: objetos, propiedades, categorías y relaciones entre objetos; situaciones, eventos, estados y tiempo; causas y efectos; conocimiento sobre el conocimiento (lo que sabemos sobre lo que otras personas saben); y muchos otros dominios menos investigados. Una representación de "lo que existe" es una ontología: el conjunto de objetos, relaciones, conceptos, y propiedades formalmente descritas para que los agentes de software puedan interpretarlas. La semántica de estos se captura como conceptos de lógica de descripción, roles e individuos, y normalmente se implementan como clases, propiedades e individuos en el lenguaje de ontología web. Las ontologías más generales se llaman ontologías superiores, que intentan proporcionar una base para todos los demás conocimientos al actuar como mediadores entre ontologías de dominio que cubren el conocimiento específico sobre un dominio de conocimiento particular (campo de interés o área de interés). Dichas representaciones formales de conocimiento pueden utilizarse en la indexación y recuperación basadas en el contenido, la interpretación de escenas, el apoyo en la toma de decisiones clínicas, el descubrimiento de conocimiento (extraer "interesantes" e inferencias accionables de grandes bases de datos) y otras áreas. La semántica de estos se captura como conceptos de lógica de descripción, roles e individuos, y normalmente se implementan como clases, propiedades e individuos en el lenguaje de ontología web. Las ontologías más generales se llaman ontologías superiores, que intentan proporcionar una base para todos los demás conocimientos al actuar como mediadores entre ontologías de dominio que cubren el conocimiento específico sobre un dominio de conocimiento particular (campo de interés o área de interés). Dichas representaciones formales de conocimiento pueden utilizarse en la indexación y recuperación basadas en el contenido, la interpretación de escenas, el apoyo en la toma de decisiones clínicas, el descubrimiento de conocimiento (extraer "interesantes" e inferencias accionables de grandes bases de datos) y otras áreas. La semántica de estos se captura como conceptos de lógica de descripción, roles e individuos, y normalmente se implementan como clases, propiedades e individuos en el lenguaje de ontología web. Las ontologías más generales se llaman ontologías superiores, que intentan proporcionar una base para todos los demás conocimientos al actuar como mediadores entre ontologías de dominio que cubren el conocimiento específico sobre un dominio de conocimiento particular (campo de interés o área de interés). Dichas representaciones formales de conocimiento pueden utilizarse en la indexación y recuperación basadas en el contenido, la interpretación de escenas, el apoyo en la toma de decisiones clínicas, el descubrimiento de conocimiento (extraer "interesantes" e inferencias accionables de grandes bases de datos) y otras áreas. y personas en el lenguaje de ontología web. Las ontologías más generales se llaman ontologías superiores, que intentan proporcionar una base para todos los demás conocimientos al actuar como mediadores entre ontologías de dominio que cubren el conocimiento específico sobre un dominio de conocimiento particular (campo de interés o área de interés). Dichas representaciones formales de conocimiento pueden utilizarse en la indexación y recuperación basadas en el contenido, la interpretación de escenas, el apoyo en la toma de decisiones clínicas, el descubrimiento de conocimiento (extraer "interesantes" e inferencias accionables de grandes bases de datos) y otras áreas. y personas en el lenguaje de ontología web. Las ontologías más generales se llaman ontologías superiores, que intentan proporcionar una base para todos los demás conocimientos al actuar como mediadores entre ontologías de dominio que cubren el conocimiento específico sobre un dominio de conocimiento particular (campo de interés o área de interés). Dichas representaciones formales de conocimiento pueden utilizarse en la indexación y recuperación basadas en el contenido, la interpretación de escenas, el apoyo en la toma de decisiones clínicas, el descubrimiento de conocimiento (extraer "interesantes" e inferencias accionables de grandes bases de datos) y otras áreas.

Entre los problemas más difíciles en la representación del conocimiento están:

- Razonamiento predeterminado y el problema de calificación

- Muchas de las cosas que las personas saben toman la forma de "suposiciones de trabajo". Por ejemplo, si un pájaro aparece en una conversación, la gente suele imaginarse un animal que tiene el tamaño de un puño, canta y vuela. Ninguna de estas cosas es verdad sobre todas las aves. John McCarthy identificó este problema en 1969 como el problema de calificación: para cualquier regla de sentido común que a los investigadores de inteligencia humana les interese representar, suele haber una gran cantidad de excepciones. Casi nada es simplemente verdadero o falso en la forma en que lo requiere la lógica abstracta. La investigación de AI ha explorado una serie de soluciones a este problema.

- La amplitud del conocimiento de sentido común

- La cantidad de hechos atómicos que la persona promedio conoce es muy grande. Los proyectos de investigación que intentan construir una base de conocimiento completa del conocimiento de sentido común (por ejemplo, Cyc) requieren enormes cantidades de laboriosa ingeniería ontológica: deben construirse, a mano, un concepto complicado a la vez.

- La forma subsimbólica de algún conocimiento de sentido común

- Gran parte de lo que las personas saben no se representa como "hechos" o "declaraciones" que puedan expresar verbalmente. Por ejemplo, un maestro de ajedrez evitará una posición de ajedrez particular porque "se siente demasiado expuesto" o un crítico de arte puede echar un vistazo a una estatua y darse cuenta de que es una falsificación. Estas son intuiciones o tendencias no conscientes y sub-simbólicas en el cerebro humano. Conocimientos como este informa, apoya y proporciona un contexto para el conocimiento simbólico y consciente. Al igual que con el problema relacionado del razonamiento subsimbólico, se espera que la IA, la inteligencia computacional o la IA estadística proporcionadas proporcionen formas de representar este tipo de conocimiento.

Planificación

Los agentes inteligentes deben ser capaces de establecer objetivos y alcanzarlos. Necesitan una forma de visualizar el futuro -una representación del estado del mundo y poder hacer predicciones sobre cómo sus acciones lo cambiarán- y ser capaces de tomar decisiones que maximicen la utilidad (o "valor") de las opciones disponibles. .

En los problemas de planificación clásicos, el agente puede suponer que es el único sistema que actúa en el mundo, lo que le permite al agente estar seguro de las consecuencias de sus acciones. Sin embargo, si el agente no es el único actor, entonces requiere que el agente pueda razonar bajo incertidumbre. Esto requiere un agente que no solo pueda evaluar su entorno y hacer predicciones, sino también evaluar sus predicciones y adaptarse en función de su evaluación.

La planificación de múltiples agentes utiliza la cooperación y competencia de muchos agentes para lograr un objetivo determinado. Comportamiento emergente como este es utilizado por los algoritmos evolutivos y la inteligencia de enjambre.

Aprendizaje

El aprendizaje automático, un concepto fundamental de la investigación de IA desde el inicio del campo, es el estudio de algoritmos de computadora que mejoran automáticamente a través de la experiencia.

El aprendizaje no supervisado es la capacidad de encontrar patrones en una corriente de entrada. El aprendizaje supervisado incluye tanto la clasificación como la regresión numérica. La clasificación se usa para determinar a qué categoría pertenece algo, después de ver una cantidad de ejemplos de cosas de varias categorías. La regresión es el intento de producir una función que describa la relación entre las entradas y salidas y predice cómo las salidas deberían cambiar a medida que cambian las entradas. Tanto los clasificadores como los alumnos de regresión pueden verse como "aproximadores de funciones" que intentan aprender una función desconocida (posiblemente implícita); por ejemplo, un clasificador de spam se puede ver como el aprendizaje de una función que se correlaciona desde el texto de un correo electrónico a una de dos categorías, "spam" o "no spam". La teoría del aprendizaje computacional puede evaluar a los estudiantes por complejidad computacional, por complejidad de la muestra (cuántos datos se requieren) u otras nociones de optimización. En el aprendizaje de refuerzo, el agente es recompensado por las buenas respuestas y castigado por las malas. El agente usa esta secuencia de recompensas y castigos para formar una estrategia para operar en su espacio problemático.

Procesamiento natural del lenguaje

El procesamiento del lenguaje natural (NLP) les da a las máquinas la capacidad de leer y comprender el lenguaje humano. Un sistema de procesamiento de lenguaje natural lo suficientemente potente permitiría las interfaces de usuario de lenguaje natural y la adquisición de conocimiento directamente de fuentes escritas por humanos, tales como textos de noticias. Algunas aplicaciones sencillas del procesamiento del lenguaje natural incluyen recuperación de información, extracción de texto, respuesta a preguntas y traducción automática. Muchos enfoques actuales usan frecuencias de co-ocurrencia de palabras para construir representaciones sintácticas de texto. Las estrategias de "búsqueda de palabras clave" para la búsqueda son populares y escalables pero tontas; una consulta de búsqueda para "perro" podría coincidir solo con la palabra literal "perro" y omitir un documento con la palabra "caniche". "Afinidad léxica" las estrategias usan la ocurrencia de palabras como "accidente" para evaluar el sentimiento de un documento. Los enfoques estadísticos NLP modernos pueden combinar todas estas estrategias y otras, y con frecuencia logran una precisión aceptable a nivel de página o párrafo, pero siguen careciendo de la comprensión semántica necesaria para clasificar bien las oraciones aisladas. Además de las dificultades habituales con la codificación del conocimiento de sentido común semántico, la PNL semántica existente a veces escasea demasiado para ser viable en aplicaciones comerciales. Más allá de la PNL semántica, el objetivo final de la PNL "narrativa" es incorporar una comprensión completa del razonamiento de sentido común. y a menudo logran una precisión aceptable en el nivel de página o párrafo, pero siguen careciendo de la comprensión semántica necesaria para clasificar bien las oraciones aisladas. Además de las dificultades habituales con la codificación del conocimiento de sentido común semántico, la PNL semántica existente a veces escasea demasiado para ser viable en aplicaciones comerciales. Más allá de la PNL semántica, el objetivo final de la PNL "narrativa" es incorporar una comprensión completa del razonamiento de sentido común. y a menudo logran una precisión aceptable en el nivel de página o párrafo, pero siguen careciendo de la comprensión semántica necesaria para clasificar bien las oraciones aisladas. Además de las dificultades habituales con la codificación del conocimiento de sentido común semántico, la PNL semántica existente a veces escasea demasiado para ser viable en aplicaciones comerciales. Más allá de la PNL semántica, el objetivo final de la PNL "narrativa" es incorporar una comprensión completa del razonamiento de sentido común.

Percepción

La percepción de la máquina es la capacidad de utilizar la entrada de sensores (como cámaras (espectro visible o infrarrojo), micrófonos, señales inalámbricas, lidar activo, sonda, radar y sensores táctiles) para deducir aspectos del mundo. Las aplicaciones incluyen reconocimiento de voz, reconocimiento facial y reconocimiento de objetos. La visión por computadora es la capacidad de analizar la información visual. Tal entrada es generalmente ambigua; un peatón gigante de cincuenta metros de altura puede producir exactamente los mismos píxeles que un peatón de tamaño normal cercano, lo que requiere que la IA juzgue la probabilidad relativa y la razonabilidad de diferentes interpretaciones, por ejemplo, al usar su "modelo de objetos" para evaluar que peatones de cincuenta metros no existen.

Movimiento y manipulación

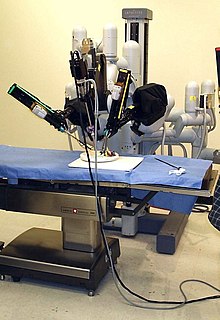

AI se usa mucho en robótica. Los brazos robóticos avanzados y otros robots industriales, ampliamente utilizados en las fábricas modernas, pueden aprender de la experiencia cómo moverse con eficiencia a pesar de la presencia de fricción y deslizamiento de la marcha. Un robot móvil moderno, cuando se le da un entorno pequeño, estático y visible, puede determinar fácilmente su ubicación y mapear su entorno; sin embargo, los entornos dinámicos, como (en endoscopia) el interior del cuerpo de respiración de un paciente, plantean un desafío mayor. La planificación de movimiento es el proceso de descomponer una tarea de movimiento en "primitivos", como los movimientos de articulaciones individuales. Tal movimiento a menudo implica un movimiento obediente, un proceso donde el movimiento requiere mantener el contacto físico con un objeto. La paradoja de Moravec generaliza que las habilidades sensoriomotoras de bajo nivel que los humanos dan por sentado son, contra intuitivamente, difícil de programar en un robot; la paradoja se llama así por Hans Moravec, quien declaró en 1988 que "es relativamente fácil hacer que las computadoras exhiban un rendimiento de nivel adulto en pruebas de inteligencia o jugar damas, y es difícil o imposible darles las habilidades de un niño de un año cuando llega a la percepción y la movilidad ". Esto se atribuye al hecho de que, a diferencia de las damas, la destreza física ha sido un objetivo directo de la selección natural durante millones de años.

Inteligencia social

La paradoja de Moravec se puede extender a muchas formas de inteligencia social. La coordinación multiagente distribuida de vehículos autónomos sigue siendo un problema difícil. La informática afectiva es un paraguas interdisciplinario que comprende sistemas que reconocen, interpretan, procesan o simulan los afectos humanos. Los éxitos moderados relacionados con la computación afectiva incluyen análisis de sentimientos textuales y, más recientemente, análisis de afectos multimodales (ver análisis de sentimientos multimodales), donde AI clasifica los afectos mostrados por un sujeto filmado en video.

A largo plazo, las habilidades sociales y la comprensión de las emociones humanas y la teoría de juegos serían valiosas para un agente social. Ser capaz de predecir las acciones de los demás al comprender sus motivos y estados emocionales permitiría a un agente tomar mejores decisiones. Algunos sistemas informáticos imitan las expresiones y emociones humanas para parecer más sensibles a la dinámica emocional de la interacción humana, o para facilitar la interacción humano-computadora. Del mismo modo, algunos asistentes virtuales están programados para hablar de manera conversacional o incluso para bromear con humor; esto tiende a dar a los usuarios ingenuos una concepción poco realista de la inteligencia de los agentes informáticos existentes.

Inteligencia general

Históricamente, proyectos como la base de conocimiento Cyc (1984-) y la iniciativa masiva de sistemas informáticos de la quinta generación japonesa (1982-1992) intentaron cubrir la amplitud de la cognición humana. Estos primeros proyectos no escaparon a las limitaciones de los modelos lógicos simbólicos no cuantitativos y, en retrospectiva, subestimaron en gran medida la dificultad de la AI entre dominios. Hoy en día, la gran mayoría de los investigadores actuales de IA trabajan en cambio en aplicaciones manejables de "IA estrecha" (como el diagnóstico médico o la navegación de automóviles). Muchos investigadores predicen que ese trabajo de "IA estrecha" en diferentes dominios individuales se incorporará finalmente en una máquina con inteligencia artificial general (AGI), combinando la mayoría de las habilidades limitadas mencionadas en este artículo y en algún punto incluso excediendo la capacidad humana en la mayoría o todas estas áreas Muchos avances tienen un significado general entre dominios. Un ejemplo de alto perfil es que DeepMind en la década de 2010 desarrolló una "inteligencia artificial generalizada" que podía aprender muchos juegos de Atari por sí misma, y más tarde desarrolló una variante del sistema que tiene éxito en el aprendizaje secuencial. Además del aprendizaje de transferencia, los avances hipotéticos de AGI podrían incluir el desarrollo de arquitecturas reflexivas que pueden involucrarse en la metaasociación teórica de decisiones, y descubrir cómo "derrochar" una base de conocimiento integral de toda la Web no estructurada. Algunos argumentan que algún tipo de "algoritmo maestro" (actualmente no descubierto) conceptualmente sencillo, pero matemáticamente difícil, podría conducir a AGI. Finalmente, algunos enfoques "emergentes" parecen simular la inteligencia humana muy de cerca,

Muchos de los problemas en este artículo también pueden requerir inteligencia general, si las máquinas deben resolver los problemas tan bien como lo hacen las personas. Por ejemplo, incluso las tareas sencillas y específicas, como la traducción automática, requieren que una máquina lea y escriba en ambos idiomas (NLP), siga el argumento del autor (razón), sepa de qué se está hablando (conocimiento) y reproduzca fielmente el original del autor. intención (inteligencia social). Un problema como la traducción automática se considera "AI-completo", porque todos estos problemas deben resolverse simultáneamente para alcanzar el rendimiento de la máquina a nivel humano.

Enfoques

No existe una teoría o paradigma unificador establecido que guíe la investigación sobre IA. Los investigadores no están de acuerdo sobre muchos problemas. Algunas de las preguntas más antiguas que han quedado sin respuesta son las siguientes: ¿debería la inteligencia artificial simular la inteligencia natural mediante el estudio de la psicología o la neurobiología? ¿O la biología humana es irrelevante para la investigación en IA, como la biología de las aves es para la ingeniería aeronáutica? ¿Se puede describir el comportamiento inteligente utilizando principios simples y elegantes (como la lógica o la optimización)? ¿O requiere necesariamente resolver una gran cantidad de problemas sin relación?

Cibernética y simulación cerebral

En las décadas de 1940 y 1950, varios investigadores exploraron la conexión entre la neurobiología, la teoría de la información y la cibernética. Algunos de ellos construyeron máquinas que usaban redes electrónicas para exhibir inteligencia rudimentaria, como las tortugas de W. Gray Walter y la Bestia Johns Hopkins. Muchos de estos investigadores se reunieron para las reuniones de la Sociedad Teleológica en la Universidad de Princeton y el Ratio Club en Inglaterra. En 1960, este enfoque fue en gran medida abandonado, aunque algunos elementos se revivirían en los años ochenta.

Simbólico

Cuando el acceso a las computadoras digitales se hizo posible a mediados de la década de 1950, la investigación sobre IA comenzó a explorar la posibilidad de que la inteligencia humana se redujera a la manipulación de símbolos. La investigación se centró en tres instituciones: Carnegie Mellon University, Stanford y MIT, y como se describe a continuación, cada una desarrolló su propio estilo de investigación. John Haugeland denominó estos enfoques simbólicos a la IA "buena IA antigua" o "GOFAI". Durante la década de 1960, los enfoques simbólicos habían logrado un gran éxito en la simulación de pensamiento de alto nivel en pequeños programas de demostración. Los enfoques basados en cibernética o redes neuronales artificiales se abandonaron o se dejaron de lado.

Simulación cognitiva

El economista Herbert Simon y Allen Newell estudiaron las habilidades de resolución de problemas humanos e intentaron formalizarlos, y su trabajo sentó las bases del campo de la inteligencia artificial, así como la ciencia cognitiva, la investigación de operaciones y la ciencia de la gestión. Su equipo de investigación utilizó los resultados de experimentos psicológicos para desarrollar programas que simulaban las técnicas que las personas usaban para resolver problemas. Esta tradición, centrada en la Universidad Carnegie Mellon culminaría eventualmente en el desarrollo de la arquitectura Soar a mediados de la década de 1980.

Basado en lógica

A diferencia de Simon y Newell, John McCarthy consideró que las máquinas no necesitaban simular el pensamiento humano, sino que deberían tratar de encontrar la esencia del razonamiento abstracto y la resolución de problemas, independientemente de si las personas usaban los mismos algoritmos. Su laboratorio en Stanford (SAIL) se centró en el uso de la lógica formal para resolver una amplia variedad de problemas, incluida la representación del conocimiento, la planificación y el aprendizaje. La lógica también fue el enfoque del trabajo en la Universidad de Edimburgo y en otras partes de Europa, que condujo al desarrollo del lenguaje de programación Prolog y la ciencia de la programación lógica.

Anti-lógica o desaliñado

Investigadores del MIT (como Marvin Minsky y Seymour Papert) descubrieron que resolver problemas difíciles en la visión y el procesamiento del lenguaje natural requerían soluciones ad-hoc; argumentaban que no existía un principio simple y general (como la lógica) que capturara todos los aspectos de comportamiento inteligente. Roger Schank describió sus enfoques "antilógicos" como "desaliñados" (en oposición a los paradigmas "limpios" de CMU y Stanford). Las bases de conocimiento de sentido común (como el Cyc de Doug Lenat) son un ejemplo de IA "desaliñada", ya que deben construirse a mano, un concepto complicado a la vez.

Basado en el conocimiento

Cuando las computadoras con memorias grandes estuvieron disponibles alrededor de 1970, los investigadores de las tres tradiciones comenzaron a desarrollar conocimiento en aplicaciones de IA. Esta "revolución del conocimiento" condujo al desarrollo y despliegue de sistemas expertos (introducidos por Edward Feigenbaum), la primera forma verdaderamente exitosa de software de AI. La revolución del conocimiento también fue impulsada por la comprensión de que se requerirían enormes cantidades de conocimiento por muchas aplicaciones simples de inteligencia artificial.

Sub-simbólico

Para la década de 1980, el progreso en la IA simbólica parecía estancarse y muchos creían que los sistemas simbólicos nunca podrían imitar todos los procesos de la cognición humana, especialmente la percepción, la robótica, el aprendizaje y el reconocimiento de patrones. Varios investigadores comenzaron a analizar enfoques "sub-simbólicos" para problemas específicos de IA. Los métodos sub-simbólicos logran acercarse a la inteligencia sin representaciones específicas de conocimiento.

Inteligencia encarnada

Esto incluye IA incorporada, situada, basada en el comportamiento y nouvelle. Investigadores del campo relacionado de la robótica, como Rodney Brooks, rechazaron la IA simbólica y se enfocaron en los problemas básicos de ingeniería que permitirían a los robots moverse y sobrevivir. Su trabajo revivió el punto de vista no simbólico de los primeros investigadores cibernéticos de la década de 1950 y reintrodujo el uso de la teoría de control en la IA. Esto coincidió con el desarrollo de la tesis de la mente encarnada en el campo relacionado de la ciencia cognitiva: la idea de que los aspectos del cuerpo (como el movimiento, la percepción y la visualización) son necesarios para la inteligencia superior.

Dentro de la robótica del desarrollo, los enfoques de aprendizaje evolutivo se elaboran para permitir a los robots acumular repertorios de nuevas habilidades a través de autoexploración autónoma, interacción social con profesores humanos y el uso de mecanismos de orientación (aprendizaje activo, maduración, sinergias motoras, etc.).

Inteligencia computacional y computación suave

El interés en las redes neuronales y el "conexionismo" fue revivido por David Rumelhart y otros a mediados de la década de 1980. Las redes neuronales artificiales son un ejemplo de computación flexible: son soluciones a problemas que no se pueden resolver con certeza lógica completa, y donde una solución aproximada a menudo es suficiente. Otros enfoques de computación blanda para AI incluyen sistemas difusos, computación evolutiva y muchas herramientas estadísticas. La aplicación de soft computing a AI es estudiada colectivamente por la emergente disciplina de la inteligencia computacional.

Aprendizaje estadístico

Gran parte del GOFAI tradicional se empantanó en ad hoc parches para la computación simbólica que funcionaba en sus propios modelos de juguete pero no lograba generalizar a los resultados del mundo real. Sin embargo, alrededor de la década de 1990, los investigadores de AI adoptaron herramientas matemáticas sofisticadas, como los modelos de Markov ocultos (HMM), la teoría de la información y la teoría de decisión bayesiana normativa para comparar o unificar arquitecturas de la competencia. El lenguaje matemático compartido permitió un alto nivel de colaboración con campos más establecidos (como matemática, economía o investigación operativa). En comparación con GOFAI, las nuevas técnicas de "aprendizaje estadístico" como HMM y redes neuronales estaban ganando niveles más altos de precisión en muchos dominios prácticos como la extracción de datos, sin necesariamente adquirir una comprensión semántica de los conjuntos de datos. El aumento de los éxitos con datos del mundo real llevó a un énfasis creciente en la comparación de diferentes enfoques frente a datos de pruebas compartidas para ver qué enfoque funcionaba mejor en un contexto más amplio que el proporcionado por los modelos idiosincrásicos de juguetes; La investigación en IA se estaba volviendo más científica. Hoy en día, los resultados de los experimentos a menudo son rigurosamente medibles, y algunas veces (con dificultad) son reproducibles. Diferentes técnicas de aprendizaje estadístico tienen diferentes limitaciones; por ejemplo, HMM básico no puede modelar las infinitas combinaciones posibles de lenguaje natural. Los críticos señalan que el cambio de GOFAI a aprendizaje estadístico a menudo también es un alejamiento de AI explicable. En la investigación de AGI, algunos estudiosos advierten contra la excesiva confianza en el aprendizaje estadístico, y argumentan que la investigación continua en GOFAI seguirá siendo necesaria para alcanzar la inteligencia general.

Integrando los enfoques

- Paradigma de agente inteligente

- Un agente inteligente es un sistema que percibe su entorno y toma medidas que maximizan sus posibilidades de éxito. Los agentes inteligentes más simples son programas que resuelven problemas específicos. Los agentes más complicados incluyen seres humanos y organizaciones de seres humanos (como empresas). El paradigma permite a los investigadores comparar directamente o incluso combinar diferentes enfoques a problemas aislados, preguntando qué agente es el mejor para maximizar una "función de objetivo" determinada. Un agente que resuelve un problema específico puede usar cualquier enfoque que funcione: algunos agentes son simbólicos y lógicos, otros son redes neuronales artificiales sub simbólicas y otros pueden usar nuevos enfoques. El paradigma también brinda a los investigadores un lenguaje común para comunicarse con otros campos, como la teoría de decisiones y la economía, que también usan conceptos de agentes abstractos. Crear un agente completo requiere que los investigadores aborden problemas realistas de integración; por ejemplo, dado que los sistemas sensoriales brindan información incierta sobre el medio ambiente, los sistemas de planificación deben poder funcionar en presencia de incertidumbre. El paradigma del agente inteligente fue ampliamente aceptado durante la década de 1990.

- Arquitecturas de agentes y arquitecturas cognitivas

- Los investigadores han diseñado sistemas para construir sistemas inteligentes a partir de agentes inteligentes que interactúan en un sistema de agentes múltiples. Un sistema de control jerárquico proporciona un puente entre la IA sub-simbólica en sus niveles reactivos más bajos y la IA simbólica tradicional en sus niveles más altos, donde las restricciones de tiempo permiten la planificación y el modelado mundial. Algunas arquitecturas cognitivas son personalizadas para resolver un problema estrecho; otros, como Soar, están diseñados para imitar la cognición humana y proporcionar una idea de la inteligencia general. Las extensiones modernas de Soar son sistemas inteligentes híbridos que incluyen componentes tanto simbólicos como sub simbólicos.

Herramientas

AI ha desarrollado una gran cantidad de herramientas para resolver los problemas más difíciles en informática. Algunos de los métodos más generales se tratan a continuación.

Búsqueda y optimización

Muchos problemas en IA se pueden resolver en teoría mediante la búsqueda inteligente a través de muchas soluciones posibles: el razonamiento se puede reducir a realizar una búsqueda. Por ejemplo, la prueba lógica se puede ver como la búsqueda de una ruta que conduce de premisas a conclusiones, donde cada paso es la aplicación de una regla de inferencia. Los algoritmos de planificación buscan a través de los árboles objetivos y subobjetivos, intentando encontrar un camino hacia un objetivo objetivo, un proceso llamado análisis de medios y fines. Los algoritmos de robótica para mover ramas y agarrar objetos utilizan búsquedas locales en el espacio de configuración. Muchos algoritmos de aprendizaje usan algoritmos de búsqueda basados en la optimización.

Las búsquedas exhaustivas simples rara vez son suficientes para la mayoría de los problemas del mundo real: el espacio de búsqueda (el número de lugares para buscar) crece rápidamente a números astronómicos. El resultado es una búsqueda que es demasiado lenta o nunca se completa. La solución, para muchos problemas, es usar "heurísticas" o "reglas generales" que prioricen las elecciones a favor de aquellas que tienen más probabilidades de alcanzar un objetivo y que lo hagan en un menor número de pasos. En algunas metodologías de búsqueda, la heurística también puede servir para eliminar por completo algunas opciones que probablemente no conduzcan a un objetivo (llamado "podar el árbol de búsqueda"). La heurística proporciona al programa una "mejor conjetura" para el camino en el que se encuentra la solución. La heurística limita la búsqueda de soluciones a un tamaño de muestra más pequeño.

Un tipo muy diferente de búsqueda adquirió importancia en la década de 1990, basado en la teoría matemática de la optimización. Para muchos problemas, es posible comenzar la búsqueda con algún tipo de adivinanza y luego refinar la adivinación gradualmente hasta que no se puedan hacer más refinamientos. Estos algoritmos se pueden visualizar como escalada ciega: comenzamos la búsqueda en un punto aleatorio en el paisaje, y luego, mediante saltos o pasos, seguimos avanzando nuestra conjetura cuesta arriba, hasta llegar a la cima. Otros algoritmos de optimización son el recocido simulado, la búsqueda de haces y la optimización aleatoria.

La computación evolutiva usa una forma de búsqueda de optimización. Por ejemplo, pueden comenzar con una población de organismos (las suposiciones) y luego permitir que muten y recombinen, seleccionando solo al más apto para sobrevivir en cada generación (refinando las suposiciones). Los algoritmos evolutivos clásicos incluyen algoritmos genéticos, programación de expresión génica y programación genética. Alternativamente, los procesos de búsqueda distribuidos pueden coordinarse a través de algoritmos de inteligencia de enjambre. Dos algoritmos de enjambre populares utilizados en la búsqueda son la optimización del enjambre de partículas (inspirado en el agrupamiento de aves) y la optimización de colonias de hormigas (inspirada en rastros de hormigas).

Lógica

La lógica se usa para la representación del conocimiento y la resolución de problemas, pero también se puede aplicar a otros problemas. Por ejemplo, el algoritmo satplanal utiliza la lógica para la planificación y la programación de la lógica inductiva es un método para el aprendizaje.

Varias formas diferentes de lógica se utilizan en la investigación de IA. La lógica proposicional implica funciones de verdad como "o" y "no". Los cuantificadores y predicados de logística de primer orden pueden expresar hechos sobre los objetos, sus propiedades y sus relaciones entre sí. La teoría de conjuntos difusos asigna un "grado de verdad" (entre 0 y 1) a afirmaciones vagas tales como "Alicia es vieja" (o rica, o alta, o hambrienta) que son demasiado lingüísticamente imprecisas para ser completamente verdaderas o falsas. La lógica difusa se utiliza con éxito en los sistemas de control para permitir a los expertos contribuir con reglas vagas como "si estás cerca de la estación de destino y te mueves rápido, aumenta la presión del freno del tren"; estas reglas vagas se pueden refinar numéricamente dentro del sistema. La lógica difusa no logra escalar bien en las bases de conocimiento;

Las lógicas predeterminadas, las lógicas no monótonas y la circunscripción son formas de lógica diseñadas para ayudar con el razonamiento predeterminado y el problema de calificación. Se han diseñado varias extensiones de lógica para manejar dominios de conocimiento específicos, como: las lógicas de descripción; cálculo de situación, cálculo de eventos y cálculo fluido (para representar eventos y tiempo); cálculo causal; cálculo de creencias; y lógicas modales.

En general, la lógica simbólica cualitativa es frágil y escasea pobremente en presencia de ruido u otra incertidumbre. Las excepciones a las reglas son numerosas, y es difícil para los sistemas lógicos funcionar en presencia de reglas contradictorias.

Métodos probabilísticos para el razonamiento incierto

Muchos problemas en IA (en razonamiento, planificación, aprendizaje, percepción y robótica) requieren que el agente opere con información incompleta o incierta. Los investigadores de IA han ideado una serie de poderosas herramientas para resolver estos problemas usando métodos de la teoría de la probabilidad y la economía.

Las redes bayesianas son una herramienta muy general que puede usarse para una gran cantidad de problemas: razonamiento (usando el algoritmo de inferencia Bayesiano), aprendizaje (usando el algoritmo de maximización de expectativas), planificación (usando redes de decisión) y percepción (usando redes bayesianas dinámicas) ) Los algoritmos probabilísticos también se pueden usar para filtrar, predecir, suavizar y encontrar explicaciones para flujos de datos, ayudando a los sistemas de percepción a analizar procesos que ocurren a lo largo del tiempo (por ejemplo, modelos ocultos de Markov o filtros de Kalman). Comparado con la lógica simbólica, la inferencia Bayesiana formal es computacionalmente costosa. Para que la inferencia sea tratable, la mayoría de las observaciones deben ser condicionalmente independientes entre sí. Los gráficos complicados con diamantes u otros "bucles" (ciclos no dirigidos) pueden requerir un método sofisticado como Markov Chain Monte Carlo, que distribuye un conjunto de caminantes aleatorios por toda la red bayesiana e intenta converger a una evaluación de las probabilidades condicionales. Las redes bayesianas se usan en XBox Live para calificar y unir jugadores; las ganancias y las pérdidas son "evidencia" de lo bueno que es un jugador. AdSense usa una red bayesiana con más de 300 millones de bordes para saber qué anuncios servir.

Un concepto clave de la ciencia de la economía es la "utilidad": una medida de cuán valioso es algo para un agente inteligente. Se han desarrollado herramientas matemáticas precisas que analizan cómo un agente puede tomar decisiones y planificar, utilizando la teoría de la decisión, el análisis de decisiones y la teoría del valor de la información. Estas herramientas incluyen modelos como los procesos de decisión de Markov, las redes de decisión dinámica, la teoría de juegos y el diseño de mecanismos.

Clasificadores y métodos estadísticos de aprendizaje

Las aplicaciones más sencillas de IA se pueden dividir en dos tipos: los clasificadores ( "si es brillante a continuación diamante") y los controladores ( "si es brillante, luego tome"). Los controladores, sin embargo, también clasifican las condiciones antes de inferir las acciones, y por lo tanto, la clasificación forma una parte central de muchos sistemas de inteligencia artificial. Los clasificadores son funciones que usan la coincidencia de patrones para determinar la coincidencia más cercana. Se pueden ajustar según los ejemplos, lo que los hace muy atractivos para su uso en IA. Estos ejemplos se conocen como observaciones o patrones. En el aprendizaje supervisado, cada patrón pertenece a una determinada clase predefinida. Una clase puede verse como una decisión que debe tomarse. Todas las observaciones combinadas con sus etiquetas de clase se conocen como un conjunto de datos. Cuando se recibe una nueva observación, esa observación se clasifica según la experiencia previa.

Un clasificador puede ser entrenado de varias maneras; hay muchos enfoques estadísticos y de aprendizaje automático. El árbol de decisión es tal vez el algoritmo de aprendizaje automático más utilizado. Otros clasificadores ampliamente utilizados son la red neuronal, el algoritmo k-vecino más próximo, los métodos kernel como la máquina de vectores de soporte (SVM), el modelo gausiano de mezcla y el extremadamente popular ingenuo Bayes clasificador. El rendimiento del clasificador depende en gran medida de las características de los datos que se van a clasificar, como el tamaño del conjunto de datos, la dimensionalidad y el nivel de ruido. Los clasificadores basados en modelos funcionan bien si el modelo supuesto es extremadamente adecuado para los datos reales. De lo contrario, si no hay disponible un modelo coincidente, y si la única preocupación es la precisión (en lugar de la velocidad o escalabilidad),

Redes neuronales artificiales

Las redes neuronales, o redes neuronales, se inspiraron en la arquitectura de las neuronas en el cerebro humano. Una simple "neurona" N acepta la entrada de muchas otras neuronas, cada una de las cuales, cuando se activan (o "disparan"), emiten un "voto" ponderado a favor o en contra de si la neurona N debería activarse El aprendizaje requiere un algoritmo para ajustar estos pesos en función de los datos de entrenamiento; un algoritmo simple (denominado "disparar juntos, conectar juntos") es aumentar el peso entre dos neuronas conectadas cuando la activación de uno desencadena la activación exitosa de otro. La red forma "conceptos" que se distribuyen entre una subred de neuronas compartidas que tienden a disparar juntas; un concepto que significa "pata" podría combinarse con una subred que significa "pie" que incluye el sonido para "pie". Las neuronas tienen un espectro continuo de activación; Además, las neuronas pueden procesar entradas de forma no lineal en lugar de ponderar los votos directos. Las redes neuronales modernas pueden aprender tanto funciones continuas como, sorprendentemente, operaciones lógicas digitales. Redes neuronales' Los primeros éxitos incluyeron predecir el mercado de valores y (en 1995) un automóvil en su mayoría autodidacta. En la década de 2010, los avances en las redes neuronales mediante el aprendizaje profundo empujaron a la IA a la conciencia pública generalizada y contribuyeron a un enorme cambio ascendente en el gasto corporativo de IA; por ejemplo, fusiones y adquisiciones relacionadas con la inteligencia artificial en 2017 fue más de 25 veces mayor que en 2015.

El estudio de las redes neuronales artificiales no aprendidas comenzó en la década anterior a la fundación del campo de la investigación en IA, en el trabajo de Walter Pitts y Warren McCullouch. Frank Rosenblatt inventó el perceptrón, una red de aprendizaje con una sola capa, similar al antiguo concepto de regresión lineal. Los primeros pioneros también incluyen a Alexey Grigorevich Ivakhnenko, Teuvo Kohonen, Stephen Grossberg, Kunihiko Fukushima, Christoph von der Malsburg, David Willshaw, Shun-Ichi Amari, Bernard Widrow, John Hopfield, Eduardo R. Caianiello y otros.

Las principales categorías de redes son redes neuronales acíclicas o de avance (donde la señal pasa en una sola dirección) y redes neuronales recurrentes (que permiten retroalimentación y recuerdos a corto plazo de eventos de entrada previos). Entre las redes de feedforward más populares se encuentran perceptrones, perceptrones multicapa y redes de base radial. Las redes neuronales se pueden aplicar al problema del control inteligente (para la robótica) o el aprendizaje, utilizando técnicas como el aprendizaje de Hebbian ("disparar juntos, conectar juntos"), GMDH o aprendizaje competitivo.

Hoy en día, las redes neuronales a menudo son entrenadas por el algoritmo de backpropagation, que existía desde 1970 como el modo inverso de diferenciación automática publicado por Seppo Linnainmaa, y fue introducido a las redes neuronales por Paul Werbos.

La memoria temporal jerárquica es un enfoque que modela algunas de las propiedades estructurales y algorítmicas de la neocorteza.

En resumen, la mayoría de las redes neuronales usan alguna forma de descenso de gradiente sobre una topología neural creada a mano. Sin embargo, algunos grupos de investigación, como Uber, argumentan que la neuroevolución simple para mutar nuevas topologías y pesos de redes neuronales puede ser competitiva con enfoques sofisticados de descenso de gradientes. Una ventaja de la neuroevolución es que puede ser menos propenso a quedar atrapado en "callejones sin salida".

Redes neuronales de alimentación profunda

El aprendizaje profundo es cualquier red neuronal artificial que puede aprender una larga cadena de enlaces causales. Por ejemplo, una red de feedforward con seis capas ocultas puede aprender una cadena causal de siete enlaces (seis capas ocultas + capa de salida) y tiene una profundidad de siete ("ruta de asignación de crédito"). Muchos sistemas de aprendizaje profundo deben poder aprender cadenas de diez o más enlaces causales de longitud. El aprendizaje profundo ha transformado muchos subcampos importantes de la inteligencia artificial, incluida la visión artificial, el reconocimiento de voz, el procesamiento del lenguaje natural y otros.

Según una visión general, Rina Dechter introdujo la expresión "Aprendizaje profundo" en la comunidad de Aprendizaje automático en 1986 y ganó impulso después de que Igor Aizenberg y sus colegas la introdujeran en Redes neuronales artificiales en 2000. Alexey publicó las primeras redes funcionales de Aprendizaje profundo. Grigorevich Ivakhnenko y VG Lapa en 1965. Estas redes se entrenan una capa a la vez. El artículo de 1971 de Ivakhnenko describe el aprendizaje de un perceptrón multicapa avanzado de alimentación directa con ocho capas, mucho más profundo que muchas redes posteriores. En 2006, una publicación de Geoffrey Hinton y Ruslan Salakhutdinov introdujo otra forma de preentrenamiento de varias capas de redes neuronales (FNN) una capa a la vez, tratando cada capa a su vez como una máquina Boltzmann no supervisada, luego usando backpropagation supervisado para el ajuste fino. De manera similar a las redes neuronales artificiales superficiales, las redes neuronales profundas pueden modelar relaciones complejas no lineales. En los últimos años, los avances en los algoritmos de aprendizaje automático y el hardware de computadora han llevado a métodos más eficientes para el entrenamiento de redes neuronales profundas que contienen muchas capas de unidades ocultas no lineales y una capa de salida muy grande.

El aprendizaje profundo a menudo usa redes neuronales convolucionales (CNN), cuyos orígenes se remontan al Neocognitron presentado por Kunihiko Fukushima en 1980. En 1989, Yann LeCunand y sus colegas aplicaron una propagación inversa a dicha arquitectura. A principios de la década de 2000, en una aplicación industrial, las CNN ya procesaban aproximadamente del 10% al 20% de todos los cheques emitidos en los EE. UU. Desde 2011, las implementaciones rápidas de CNN en GPU han ganado muchos concursos de reconocimiento de patrones visuales.

CNN con 12 capas convolucionales se utilizaron junto con el aprendizaje de refuerzo por parte de Deepmind, "AlphaGo Lee", el programa que derrotó a un campeón Go superior en 2016.

Redes neuronales recurrentes profundas

Al principio, el aprendizaje profundo también se aplicó al aprendizaje secuencial con redes neuronales recurrentes (RNN) que en teoría están completas y pueden ejecutar programas arbitrarios para procesar secuencias arbitrarias de datos. La profundidad de un RNN es ilimitada y depende de la longitud de su secuencia de entrada; por lo tanto, un RNN es un ejemplo de aprendizaje profundo. Los RNN se pueden entrenar por descenso en gradiente pero sufren el problema del gradiente de fuga. En 1992, se demostró que el preentrenamiento no supervisado de una pila de redes neuronales recurrentes puede acelerar el posterior aprendizaje supervisado de problemas secuenciales profundos.

Numerosos investigadores ahora usan variantes de un NN recurrente de aprendizaje profundo llamado la red de memoria a corto plazo larga (LSTM) publicada por Hochreiter & Schmidhuber en 1997. LSTM a menudo es entrenado por la Clasificación Temporal Conexionista (CTC). En Google, Microsoft y Baidu este enfoque ha revolucionado el reconocimiento de voz. Por ejemplo, en 2015, el reconocimiento de voz de Google experimentó un dramático salto de rendimiento del 49% a través de LSTM capacitado en CTC, que ahora está disponible a través de Google Voice para miles de millones de usuarios de teléfonos inteligentes. Google también usó LSTM para mejorar la traducción automática, el lenguaje y el lenguaje multilingüe. Tratamiento. LSTM combinado con CNN también mejoró el subtitulado automático de imágenes y una plétora de otras aplicaciones.

Evaluar el progreso

AI, como la electricidad o la máquina de vapor, es una tecnología de uso general. No hay consenso sobre cómo caracterizar en qué tareas la inteligencia artificial tiende a sobresalir. Si bien proyectos como AlphaZerohan logrado generar su propio conocimiento desde cero, muchos otros proyectos de aprendizaje automático requieren grandes conjuntos de datos de capacitación. El investigador Andrew Ng ha sugerido, como una "regla general muy imperfecta", que "casi cualquier cosa que un humano típico pueda hacer con menos de un segundo de pensamiento mental, probablemente ahora o en el futuro cercano podamos automatizar el uso de la IA". La paradoja de Moravec sugiere que la IA retrasa a los humanos en muchas tareas que el cerebro humano ha desarrollado específicamente para funcionar bien.

Los juegos proporcionan un punto de referencia muy publicitado para evaluar las tasas de progreso. AlphaGo en 2016 puso fin a la era de los puntos de referencia clásicos de los juegos de mesa. Los juegos de conocimiento imperfecto ofrecen nuevos desafíos a la IA en el área de la teoría de juegos. Los deportes electrónicos como StarCraft continúan brindando puntos de referencia públicos adicionales. Hay muchos concursos y premios, como el Desafío Imagenet, para promover la investigación en inteligencia artificial. Las principales áreas de competencia incluyen la inteligencia general de la máquina, el comportamiento conversacional, la minería de datos, los automóviles robóticos y el fútbol robot, así como los juegos convencionales.

El "juego de imitación" (una interpretación de la prueba de Turing de 1950 que evalúa si una computadora puede imitar a un ser humano) hoy en día se considera demasiado explotable como para ser un punto de referencia significativo. Una derivada de la prueba de Turing es la prueba de Turing pública completamente automatizada para distinguir computadoras y seres humanos (CAPTCHA). Como su nombre lo indica, esto ayuda a determinar que un usuario es una persona real y no una computadora que se hace pasar por humana. En contraste con la prueba estándar de Turing, CAPTCHA es administrado por una máquina y dirigido a un ser humano en lugar de ser administrado por un ser humano y dirigido a una máquina. Una computadora le pide a un usuario que complete una prueba simple y luego genera una calificación para esa prueba. Las computadoras no pueden resolver el problema, por lo que se considera que las soluciones correctas son el resultado de una persona que toma la prueba.

Las pruebas propuestas de "inteligencia universal" apuntan a comparar qué tan bien funcionan las máquinas, los seres humanos e incluso los animales no humanos en conjuntos de problemas que son genéricos como sea posible. En un extremo, el conjunto de pruebas puede contener todos los problemas posibles, ponderados por la complejidad de Kolmogorov; desafortunadamente, estos grupos de problemas tienden a estar dominados por ejercicios empobrecidos de emparejamiento de patrones donde una IA ajustada puede fácilmente exceder los niveles de desempeño humano.

Aplicaciones

AI es relevante para cualquier tarea intelectual. Las técnicas modernas de inteligencia artificial son omnipresentes y son demasiado numerosas para enumerarlas aquí. Con frecuencia, cuando una técnica alcanza el uso general, ya no se considera inteligencia artificial; este fenómeno se describe como el efecto AI.

Los ejemplos de AI de alto perfil incluyen vehículos autónomos (como drones y automóviles sin conductor), diagnóstico médico, creación de arte (como poesía), demostración de teoremas matemáticos, juegos (como Chess o Go), motores de búsqueda (como Búsqueda de Google), asistentes en línea (como Siri), reconocimiento de imágenes en fotografías, filtrado de correo no deseado, predicción de decisiones judiciales y publicidad en línea dirigida.

Con las redes sociales superando a la televisión como fuente de noticias para los jóvenes y las organizaciones de noticias dependen cada vez más de las plataformas de medios sociales para generar distribución, las principales editoriales ahora usan tecnología de inteligencia artificial (IA) para publicar historias de manera más efectiva y generar mayores volúmenes de tráfico.

Cuidado de la salud

La inteligencia artificial se está introduciendo en la industria de la asistencia sanitaria ayudando a los médicos. Según Bloomberg Technology, Microsoft ha desarrollado AI para ayudar a los médicos a encontrar los tratamientos adecuados para el cáncer. Hay una gran cantidad de investigación y medicamentos desarrollados relacionados con el cáncer. En detalle, hay más de 800 medicamentos y vacunas para tratar el cáncer. Esto afecta negativamente a los médicos, porque hay demasiadas opciones para elegir, lo que hace más difícil elegir los medicamentos adecuados para los pacientes. Microsoft está trabajando en un proyecto para desarrollar una máquina llamada "Hannover". Su objetivo es memorizar todos los documentos necesarios para el cáncer y ayudar a predecir qué combinaciones de medicamentos serán más eficaces para cada paciente. Un proyecto en el que se está trabajando actualmente es combatir la leucemia mieloide, un cáncer fatal donde el tratamiento no ha mejorado en décadas. Se informó que otro estudio descubrió que la inteligencia artificial era tan buena como la de los médicos entrenados en la identificación de cánceres de piel. Otro estudio está utilizando la inteligencia artificial para tratar de controlar a múltiples pacientes de alto riesgo, y esto se hace al hacer numerosas preguntas a cada paciente en función de los datos adquiridos de las interacciones entre el médico y el paciente.

Según CNN, un estudio reciente de cirujanos en el Children's National Medical Center en Washington demostró con éxito la cirugía con un robot autónomo. El equipo supervisó al robot mientras realizaba una cirugía de tejidos blandos, cosiendo el intestino de un cerdo durante una cirugía abierta, y haciéndolo mejor que un cirujano humano, afirmó el equipo. IBM ha creado su propia computadora de inteligencia artificial, IBM Watson, que ha vencido a la inteligencia humana (en algunos niveles). ¡Watson no solo ganó en el programa de juegos Jeopardy! contra ex campeones, pero fue declarado héroe después de diagnosticar con éxito a una mujer que padecía leucemia.

Automotor

Los avances en IA han contribuido al crecimiento de la industria automotriz a través de la creación y evolución de vehículos autónomos. A partir de 2016, hay más de 30 empresas que utilizan AI en la creación de automóviles sin conductor. Algunas compañías involucradas con AI incluyen Tesla, Google y Apple.

Muchos componentes contribuyen al funcionamiento de los autos sin conductor. Estos vehículos incorporan sistemas como el frenado, el cambio de carril, la prevención de colisiones, la navegación y el mapeo. Juntos, estos sistemas, así como las computadoras de alto rendimiento, están integrados en un vehículo complejo.

Los recientes desarrollos en automóviles autónomos han hecho posible la innovación de los camiones autónomos, aunque todavía están en fase de prueba. El gobierno del Reino Unido ha aprobado una legislación para comenzar las pruebas de pelotones de camiones autónomos en 2018. Los pelotones de camiones autodirigidos son una flota de camiones autónomos que siguen el ejemplo de un camión sin conductor, por lo que los pelotones de camiones no completamente autónomo todavía. Mientras tanto, Daimler, una corporación automovilística alemana, está probando la Freightliner Inspiration, que es un camión semiautónomo que solo se utilizará en la carretera.

Un factor principal que influye en la capacidad de un automóvil sin conductor para funcionar es el mapeo. En general, el vehículo estaría preprogramado con un mapa del área que se conduce. Este mapa incluiría datos sobre las aproximaciones de la luz de la calle y las alturas de la acera para que el vehículo esté al tanto de su entorno. Sin embargo, Google ha estado trabajando en un algoritmo con el objetivo de eliminar la necesidad de mapas preprogramados y, en su lugar, crear un dispositivo que pueda ajustarse a una variedad de entornos nuevos. Algunos autos sin conductor no están equipados con volantes o pedales de freno, por lo que también se han realizado investigaciones centradas en la creación de un algoritmo que sea capaz de mantener un entorno seguro para los pasajeros en el vehículo a través de la velocidad y las condiciones de conducción.

Otro factor que influye en la capacidad de un automóvil sin conductor es la seguridad del pasajero. Para hacer un automóvil sin conductor, los ingenieros deben programarlo para manejar situaciones de alto riesgo. Estas situaciones podrían incluir una colisión frontal con peatones. El objetivo principal del automóvil debe ser tomar una decisión que evite golpear a los peatones y salvar a los pasajeros en el automóvil. Pero existe la posibilidad de que el automóvil necesite tomar una decisión que ponga a alguien en peligro. En otras palabras, el automóvil tendría que decidir salvar a los peatones o a los pasajeros. La programación del automóvil en estas situaciones es crucial para un automóvil exitoso sin conductor.

Finanzas y economía

Las instituciones financieras han utilizado durante mucho tiempo los sistemas de redes neuronales artificiales para detectar cargos o reclamaciones fuera de la norma, marcándolos para la investigación humana. El uso de inteligencia artificial en la banca se remonta a 1987, cuando Security Pacific National Bank en EE. UU. Estableció una Fuerza de Tarea de Prevención del Fraude para contrarrestar el uso no autorizado de tarjetas de débito. Programas como Kasisto y Moneystream están usando AI en servicios financieros.

Los bancos usan sistemas de inteligencia artificial hoy para organizar operaciones, mantener libros, invertir en acciones y administrar propiedades. AI puede reaccionar a los cambios de la noche a la mañana o cuando el negocio no está teniendo lugar. En agosto de 2001, los robots vencieron a los humanos en una competencia de comercio financiero simulado. AI también ha reducido el fraude y los delitos financieros al monitorear los patrones de comportamiento de los usuarios ante cualquier cambio o anomalía anormal.

El uso de máquinas de IA en el mercado en aplicaciones tales como el comercio en línea y la toma de decisiones ha cambiado las principales teorías económicas. Por ejemplo, las plataformas de compra y venta basadas en AI han cambiado la ley de la oferta y la demanda en el sentido de que ahora es posible estimar fácilmente las curvas individualizadas de demanda y oferta y, por lo tanto, precios individualizados. Además, las máquinas de IA reducen la asimetría de información en el mercado y, por lo tanto, hacen que los mercados sean más eficientes y reducen el volumen de intercambios. Además, la IA en los mercados limita las consecuencias del comportamiento en los mercados y hace que los mercados sean más eficientes. Otras teorías en las que la IA ha tenido impacto incluyen la elección racional, las expectativas racionales, la teoría de juegos, el punto de inflexión de Lewis, la optimización de la cartera y el pensamiento contrafactual.

Videojuegos

En los videojuegos, la inteligencia artificial se usa rutinariamente para generar un comportamiento dinámico y útil en personajes no jugadores (NPC). Además, las técnicas de IA bien entendidas se usan de forma rutinaria para determinar la ruta. Algunos investigadores consideran que NPC AI en los juegos es un "problema resuelto" para la mayoría de las tareas de producción. Los juegos con más IA atípica incluyen el director de IA de Left 4 Dead (2008) y el entrenamiento neuroevolutivo de pelotones en Supreme Commander 2 (2010).